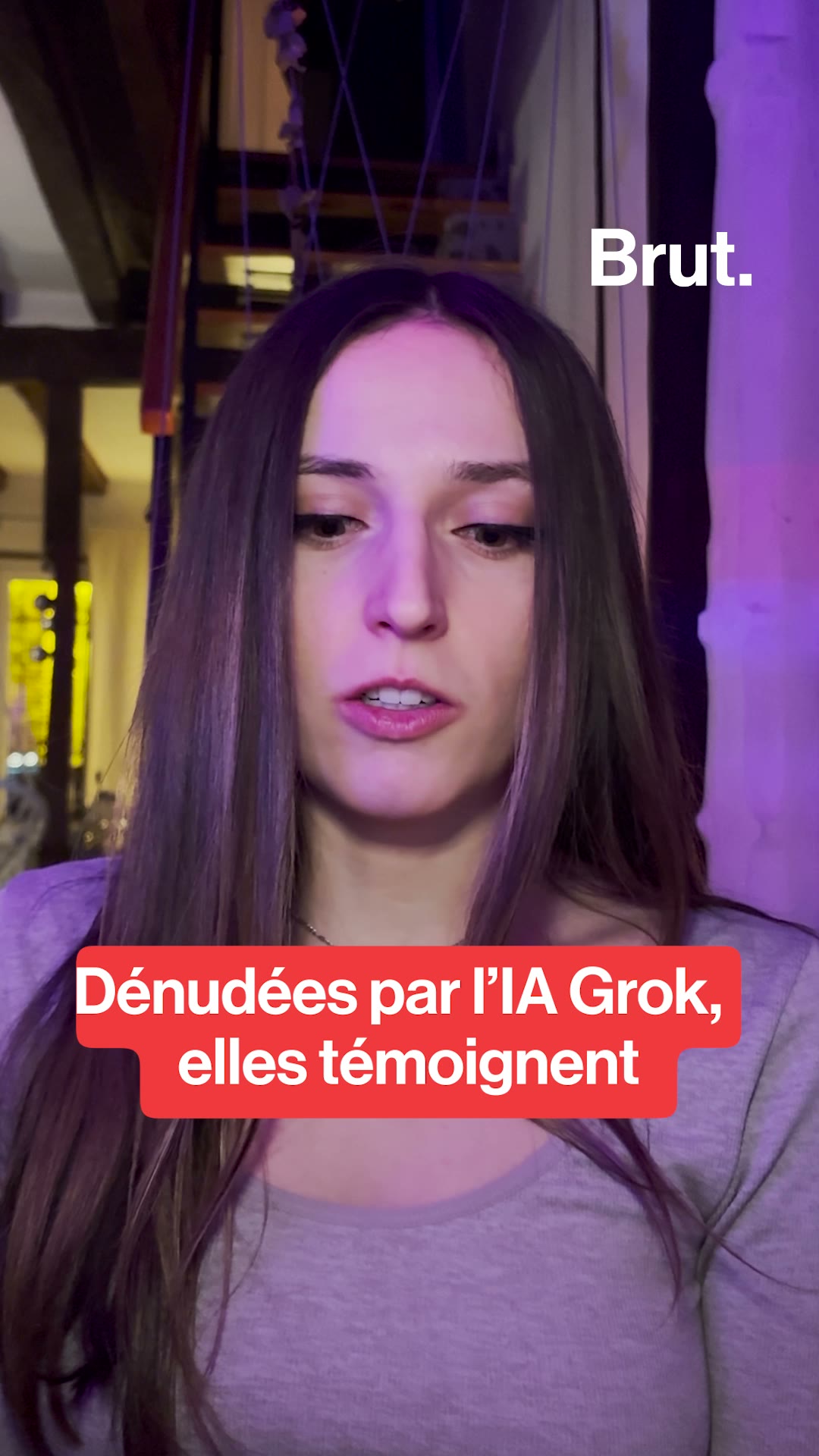

Droit des femmes

Le droit des femmes désigne l’ensemble des luttes et des acquis juridiques visant à garantir l’égalité entre les sexes.

Lire plusToutes les vidéos

Droit des femmes

Le droit des femmes désigne l’ensemble des luttes et des acquis juridiques visant à garantir l’égalité entre les sexes. Ce tag revient sur les combats féministes historiques et actuels : accès à l’éducation, lutte contre les violences, droit à disposer de son corps, égalité salariale… Un enjeu mondial, toujours d’actualité.

Remonter